近日,高盛发布了一项最新的研究报告称,随着人工智能的快速发展,对于算力的需求也是越来越高,由此也带来了对于电力需求的大增,预计到2030年,全球AI数据中心对于电力的需求将增长160%,届时美国整体数据中心对于电力的需求量,在美国总电力需求当中的占比将从2022年的3%增加至8%,需要额外500亿美元的资本支出。

2030年全球AI数据中心对于电力的需求将增长160%

高盛称,2022年美国来自数据中心的电力需求在总的电力需求当中的份额为3%,但预计到2030年将增加至8%,电力需求年复合增长率为2.4%。相比之下,过去20年数据中心发电量年复合增率不到0.5%,过去10年发电量年增率为0%。

高盛表示,随着数据中心的持续扩张,电网也必须扩张,能源来源必须多样化,以充分利用天然气、太阳能和核能,基础设施也必须扩展以支持不断增长的电网。

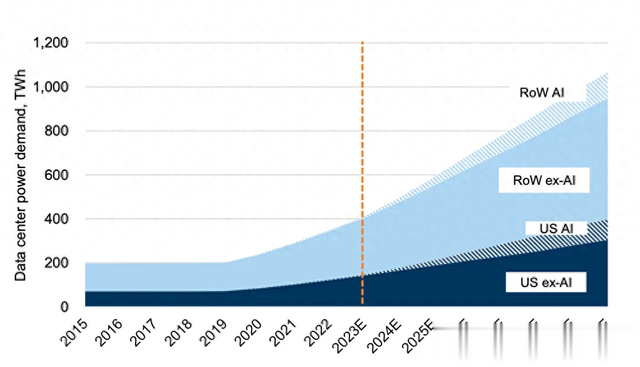

以下是高盛的图表,展示了过去和未来美国国内外数据中心在使用和不使用人工智能的情况下对电力的需求增加。

报告指出,预计未来五年电力需求将以本世纪初以来从未有过的速度增长。高盛也估计未来七年数据中心电力使用的三种场景,在这三种情况下,电力需求预计都会上升。

下图展示了未来七年(2023-2030年)数据中心用电的三种情况。在乐观的情况下,电力消耗不会受到限制,前提是相关电力公司的技术支出是充足的。

美国电力供应短期内仍将依赖天然气

此前外媒报道也显示,OpenAI的生成式AI聊天机器人ChatGPT每天可能要消耗超过50万千瓦时的电力。如果生成式AI被进一步广泛采用,未来耗电量可能会更多。

根据英伟达的资料显示,H100 GPU的峰值功耗为700瓦。那么10万张H100 GPU的峰值功耗将高达7000万瓦,如果在算上这些GPU所需要配套的其他部件及散热所需的功耗,整体的功耗可能将达到1亿瓦。

根据市场调研机构Factorial Funds的报告显示,OpenAI的文字生成视频模型Sora一个月内使用4,200至10,500片H100 GPU,其中单个H100能在约12分钟内生成一个一分钟视频,或者每小时约5个一分钟视频。而在Sora高峰时期需要72万个H100 GPU。也就是这么庞大的一个AI数据中心每小时的能耗将会超过7.2亿瓦时。

荷兰国家银行数据科学家Alex de Vries在一篇论文中估计,到2027年,整个人工智能行业每年将消耗85至134太瓦时(1太瓦时=10亿千瓦时)的电力。这个电量足以匹敌肯尼亚、危地马拉和克罗地亚三国的年总发电量。

富国银行近期也发布了评价未来电力需求的报告指出,随着AI兴起、半导体和电池制造的扩张,以及车辆电气化,电力公司必须确保能源安全,美国电力成长十年持平后,预计到2030年美国整体电力需求将增加20%,仅AI数据中心就预计将为美国增加约323太瓦时的电力需求。仅美国的AI的电力需求预计将达到纽约市目前48太瓦时的年用电量的7倍以上。

而根据资料显示,2020年美国电力比较充沛的加州电网总发电量达19万GWh,换算下来,每个小时的发电量约为21.7GWh,虽然这个量不小,但是也是不够用。在2020年8月,受热浪影响,加州在周末还实施了轮流停电措施。如果一下子要增加1亿瓦时能耗的AI数据中心,显然这对于电力系统将会带来巨大的负担。

数据中心电源管理公司总裁Lancium称,至少在AI方面,电力就是一切。科技业变革对电力的需求如此庞大,相较1 GW(10亿瓦=100万千瓦)的电力足以满足100万人的家庭需求,100 GW的电力足以满足全球10%的照明需求,反应“我们正在见证历史上对AI的最大规模资本注入。”

美国的电力供应短期内仍将依赖天然气,美国管线营运商认为,在可预见的未来,大量新的核电容量不会上线,建设将可再生能源连接到电网的输电线需要数年时间,因此天然气必须在未来几年发挥重要作用。

高盛估计,美国将需要500亿美元的资本支出来满足日益增长的电力需求,其中60%用于天然气,40%用于可再生能源。

最近微软签署价值100亿美元的绿色能源协议,是至今最大一笔购买再生能源的企业协议,将启动全世界再生能源建设热潮。分析师认为,希望利用AI热潮的人需要弄清楚电力在哪里,如何获得电力,以及在哪里可以最快速地建立数据中心来提供AI所需的电力,同时控制成本。

编辑:芯智讯-浪客剑