报告出品方:东吴证券

以下为报告原文节选

------

一、如何看待OEM自研智驾芯片?

芯片分类:四类主流芯片覆盖市场不同应用场景

当前市场上流通的主流芯片包括四大类:1)处理器芯片,包括CPU、GPU、DSP、和MCU,负责系统的运算和控制核心,以及信息处理和程序运行的最终执行单元。2)存储器芯片:包括静态(SRAM)以及动态(DRAM)随机存取存储器等,用于数据的存储。3)模拟-数字转换器(ADC) 和 数字-模拟转换器 (DAC):这两种芯片分别用于模拟信号和数字信号的互相转换,广泛应用于传感器和测量仪器中。4)片上系统(SoC):集成微控制器/处理器/存储器/通信接口和传感器等元件,通过简单编程可以实现丰富的功能。

AI芯片是属于SoC片上系统芯片的特殊分支,是指针对人工智能算法做了特殊加速设计的芯片,专门用于处理人工智能应用中的大量计算。

AI芯片分类:GPU以及ASIC主导训练/推理应用

为满足行业发展对于芯片处理性质单一但规模庞大的数据计算的需求,产业基于GPU图像处理器的并行计算能力持续升级,开发了以极致性能为代表的GPU以及以极致功耗为代表的ASIC芯片,以及介于二者之间,兼具灵活性和高性能的FPGA等不同类型芯片,应用于包括云端训练以及边缘段推理等不同场景。未来,AI芯片将持续迭代,开发高度模拟人脑计算原理的类脑芯片,围绕人脑的神经元/脉冲等环节,实现计算能力的飞跃提升以及能耗的大幅下降。

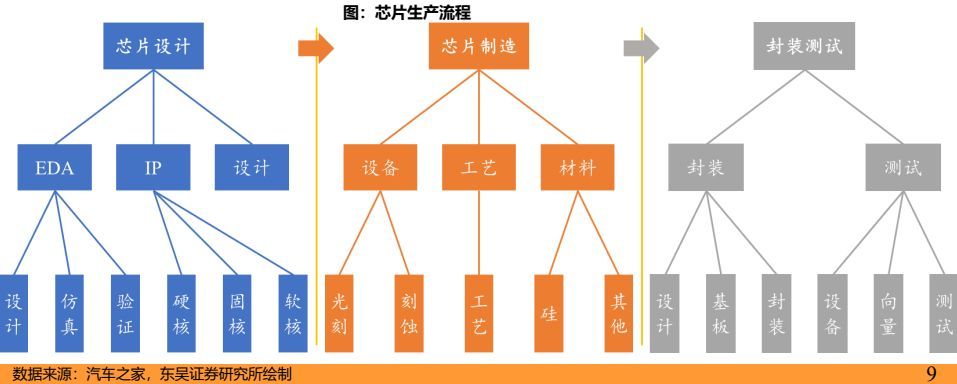

芯片生产:设计为基础,制造最核心,封测保性能

芯片制造分为三大步骤,分别是芯片设计、芯片制造、封装测试

➢ 芯片设计:在EDA软件工具的支持下,通过购买授权+自主开发获得IP,遵循集成电路设计仿真验证流程,完成芯片设计。首先明确芯片目的(逻辑/储存/功率),编写芯片细节,形成完整HDL代码;其次利用EDA软件(高制程工艺软件市场集中度高)将HDL代码转为逻辑电路图,进一步转为物理电路图,最后制作成光掩模。

➢ 芯片制造:壁垒最高!三大关键工序光刻、刻蚀、沉积,在生产过程中不断重复循环三工序,最终制造出合格的芯片。过程中要用到三种关键设备,分别是光刻机、刻蚀机、薄膜沉积设备。

➢ 封装测试:测试是指在半导体制造的过程中对芯片进行严格的检测和测试,以确保芯片的质量和稳定性和性能;而封装则是将测试完成的芯片进行封装,以便其被应用在各种设备中。

设计环节:EDA软件格局集中,IP模块是核心产权

EDA:(Electronic Design Automation)电子设计自动化,常指代用于电子设计的软件。目前,Synopsys、Cadence和Mentor(Siemens EDA)占据着90%以上的市场份额。在10纳米以下的高端芯片设计上,其占有率甚至高达100%。国产EDA工具当前距离海外龙头有较大差距。

IP核:指一种事先定义、经过验证的、可以重复使用,能完成特定功能的模块(类似于excel模板),物理层面是指构成大规模集成电路的基础单元,SoC甚至可以说是基于IP核的复用技术。

其包括处理器IP(CPU/GPU/NPU/VPU/DSP/ISP…)、接口IP(USB/SATA/HDMI…)、存储器IP等等几类。对于当前智驾领域AI芯片而言,常用IP核包括CPU、GPU、ISP、NPU、内存控制器、对外接口(以太网【用于连接不同车身设备以交换数据】和PCIe接口【用于主板上的设备间通讯】)等。

制造环节:设备/工艺/材料多环节,高壁垒高集中度

芯片制造三大关键工序:光刻、刻蚀、沉积,三大工序在生产过程中不断循环,最终制造出合格的芯片;其中,设备+工艺+材料等环节尤为关键;芯片制造以台积电、三星、英特尔寡头垄断。

➢ 设备:三大关键工序要用到光刻机、刻蚀机、薄膜沉积设备三种关键设备,占所有设备投入的22%、22%、20%左右,是三种难度和壁垒最高的半导体设备。

➢ 工艺:芯片制造需要2000道以上工艺制程,主要包括光刻、刻蚀、化学气相沉积、物理气相沉积、离子植入、化学机械研磨、清洗、晶片切割等8道核心工艺。

➢ 材料:硅晶圆和光刻胶是最核心的两类材料,90%以上的芯片在硅晶圆上制造,光刻胶是制造过程最重要的耗材,半导体光刻胶壁垒最高,全球CR5接近90%。

底软以及工具链开发是自研智驾芯片的后端壁垒

异构计算架构/生态开发环境:以英伟达CUDA和华为CANN为代表的核心软件层,用于调度AI芯片和通用芯片的底层算子,并针对性地进行加速和执行,更好地发挥出芯片的算力,实现效率最大化。

SDK软件开发工具包(Software Development Kit):是指软件工程师为特定的软件包、软件框架、硬件平台、操作系统等建立应用软件时的开发工具的集合;借助SDK,应用开发者可以迅速基于特定平台开发差异化上层应用。

智驾芯片自研聚焦设计环节中的IP核:NPU/ISP等

智驾边缘端芯片以自研NPU为主,塑造产品差异化。

智驾SoC芯片以CPU中央处理器+GPU图形处理器+DSP数字信号处理器+ISP图片处理器+NPU(AI计算单元)以及I/O接口以及存储器等IP核集成组装而成,其中NPU/CPU/ISP等环节对智驾边缘段数据处理更为重要。产业链玩家自研智驾芯片即指芯片自主设计IP核,尤其是NPU,其次ISP等,CPU以及GPU多以外采ARM/英伟达等为主,技术相对成熟,其余I/O接口以及存储器同样依赖外部采购。

云端芯片多采用集中外采形式,主要系云端芯片对于能耗以及CPU/GPU综合能力要求较低,仅对强AI算力也即单一GPU/NPU的计算能力有较高需求,规模效应是核心优势,外部方案更成熟。

边缘端:自研芯片势在必行,强化软硬件适配提效

智能驾驶产品力的竞争短期看产品体验,中期看迭代效率,长期看降本能力。

➢ 1)短期——算力强冗余阶段:产品体验取决于软件算法成熟度(背后是数据量为支撑),与智驾芯片自研相关性较低,高通/英伟达/华为/地平线等多家第三方供应商产品均可满足。

➢ 2)中期——算力提效阶段:在保有量提升带动数据飞跃增长后,前期冗余布局的边缘端硬件的利用效率进一步提升,同时也对底软更好地调用芯片算力提出更高要求,自研芯片NPU/ISP等核心环节的优势显现,迭代速率更快。

➢ 3)长期——协同并进阶段:足量数据喂养下软硬件能力协同提升,保障功能体验的同时优化成本结构,要求玩家对底层硬件具备全栈深入了解。

云端:自研利好数据闭环增效,一体化整合更优

云端芯片自研有利于数据全流程闭环,提升数据利用率和算法迭代速率,但同时成本负担较大。

➢ 智驾数据量指数级增长驱动智驾功能升级,数据的存储、优化、利用、训练等各环节对云端训练/传输等要求较高,“数据驱动”的智驾迭代模式下,数据闭环的模型训练与AI计算平台相互赋能,同时提升多元异构数据的清洗和标注效率,有利于提升算法迭代升级速率。

➢ 云端超算中心芯片与边缘端芯片不同,其能力依赖GPU/NPU等的单一计算能力,前期研发和中期运维以及后期应用部署成本均较高,需要强大规模效应进行摊薄。

可行性分析:对照地平线/黑芝麻,芯片自研可为

对照国内智驾芯片初创企业地平线、黑芝麻智能等公司芯片自研历程,【千人研发规模;30~50亿研发投入;2~3年耗时】可完成智驾芯片全自研以及配套解决方案落地:

地平线:自2015年成立至2024年,公司累计融资171亿元人民币,创收30亿元以上,截至23年底在手现金114亿元,已完成涵盖L2/L3级别SoC芯片和配套工具链/底软等的开发和规模量产。

黑芝麻智能:自2017年成立至2024年,累计融资30亿元人民币,创收4.5亿元以上,截至22年底在手现金不足10亿元,同样完成L2级SoC智驾芯片(NPU/ISP)等IP核自研开发和规模量产。

➢ 研发耗时:1)地平线2015年成立,2019年首款智驾芯片落地;2024年预计落地征程6系列支持L3级别芯片;2)黑芝麻智能2017年成立,2019年首款智驾芯片落地,2024年大算力落地。

➢ 团队规模:截至2023年底,地平线/黑芝麻智能研发团队人数分别有1478/950人。

➢ 资金投入:地平线2021年至2023年,研发费用累计投入54亿元,黑芝麻智能2020年至2023年研发费用累计投入30亿元,大额研发投入保证智驾芯片持续迭代升级。

二、第三方玩家自研智驾芯片成效如何?

厂商布局比较:英伟达/特斯拉最全,其余快速跟进

综合OEM主机厂以及Tier环节供应商,我们梳理自研智驾芯片并已有或即将有成熟产品量产出货的玩家进行横向对比:英伟达/特斯拉目前云端&边缘端芯片硬件以及对应底软&工具链布局最为完善,高通聚焦边缘端自研&Tier1落地模式迅速落地,地平线/黑芝麻智能由低到高布局。

2.1、英伟达:高举高打,算力+生态最强音

发展历程:由GPU起构建软硬件壁垒,拓展全行业

英伟达成立于1993年,由黄仁勋联合Sun公司两位年轻工程师共同创立。最初致力于GPU的研发,1999年成功上市。随着GPU在图形和高性能计算领域的成功,英伟达逐渐扩展至人工智能、深度学习、自动驾驶和医疗等领域。公司的GPU技术在科学计算、游戏和专业工作站等领域取得巨大成功,成为全球领先的半导体公司之一。

CUDA:更好加速GPU计算,构建英伟达生态壁垒

CUDA 是 NVIDIA 发明的一种并行计算平台和编程模型,全称Compute Unified Device Architecture它通过更好地调用图形处理器 (GPU) 的处理能力,对算法运行进行加速,可大幅提升计算性能,并构建英伟达自身的软件生态。CUDA的优势在于:1)并行计算:CUDA允许开发者使用GPU的大量核心进行并行计算,以加速各种计算密集型任务;2)高效内存管理:CUDA提供了高效的内存管理机制,包括全局内存、共享内存、常量内存等,可以最大限度地利用GPU的内存资源;3)强大的工具支持:CUDA提供了一系列强大的工具支持,包括CUDA编译器、CUDA调试器、CUDA性能分析器等,可以帮助开发者更加高效地开发和调试CUDA程序。

--- 报告摘录结束 更多内容请阅读报告原文 ---

报告合集专题一览 X 由【报告派】定期整理更新

(特别说明:本文来源于公开资料,摘录内容仅供参考,不构成任何投资建议,如需使用请参阅报告原文。)

精选报告来源:报告派科技 / 电子 / 半导体 /

人工智能 | Ai产业 | Ai芯片 | 智能家居 | 智能音箱 | 智能语音 | 智能家电 | 智能照明 | 智能马桶 | 智能终端 | 智能门锁 | 智能手机 | 可穿戴设备 |半导体 | 芯片产业 | 第三代半导体 | 蓝牙 | 晶圆 | 功率半导体 | 5G | GA射频 | IGBT | SIC GA | SIC GAN | 分立器件 | 化合物 | 晶圆 | 封装封测 | 显示器 | LED | OLED | LED封装 | LED芯片 | LED照明 | 柔性折叠屏 | 电子元器件 | 光电子 | 消费电子 | 电子FPC | 电路板 | 集成电路 | 元宇宙 | 区块链 | NFT数字藏品 | 虚拟货币 | 比特币 | 数字货币 | 资产管理 | 保险行业 | 保险科技 | 财产保险 |