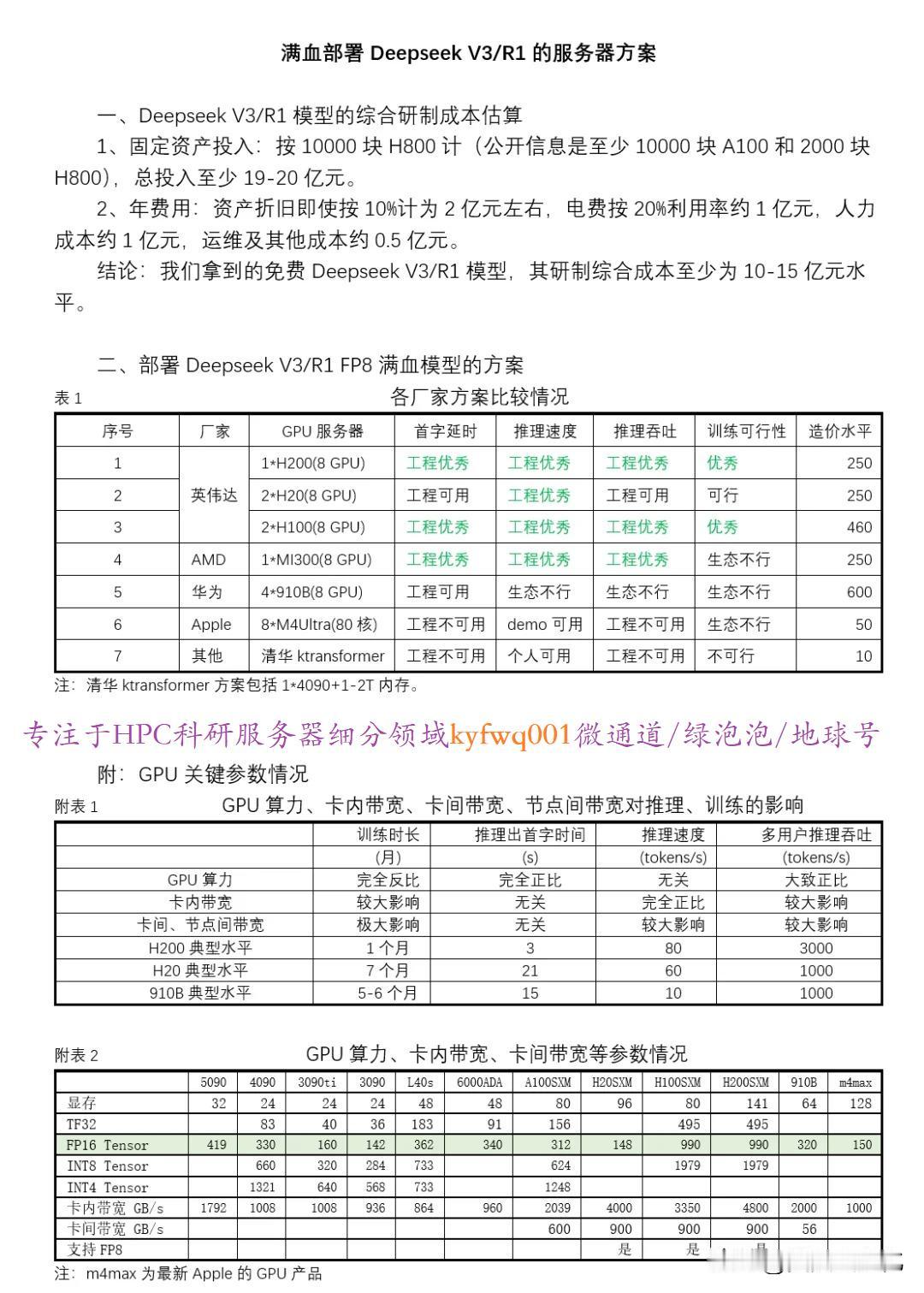

满血DeepSeek r1/v3部署方案H100\200与910B参考[V5][点亮平安灯][给力] 高校科研、科研单位院所,算力中心,人工智能创新企业、大型国企等可以参考[玫瑰][玫瑰][玫瑰] sglang目前支持最好,开启nextN(MTP)和torch-compile后,一组h200单线程可以到77t/s。vllm刚支持了MTP,具体还没看到实测。最近vllm不如sglang务实和努力。 推理的速度目前差8倍[点亮平安灯]。华为10t/s,英伟达目前已经快到80t/s。agent场景下,v3输出也要1000token左右完成一个thinking,如果用r1做更长,华为是100s才开始动,英伟达是12s。agent应用场景如自动编制文档,20个action起步,华为时间大概30分钟,英伟达是4分钟。 机器学习deepseek人工智能AI智囊高校研究生博士科研技术大模型 @北京大学@武汉大学@浙江大学@中国人民大学@厦门大学@重庆大学@山东大学