新一代智能座舱正在发生深度变革,智能座舱4.0时代正在加速到来。

一方面,舱驾一体方案即将进入量产周期,智能座舱硬件平台、软件架构、应用开发模式、组织架构等方面均将发生变化,这对车企、智驾和智舱供应链均带来巨大影响。

特别需要提到的是,舱驾一体大的趋势下,对系统供应商的要求更高也更具全面。系统供应商需要既懂智舱,也要懂智驾,并且架构设计能力、软硬件能力、AI优化能力等等都要提升。

另一方面,AI大模型加速导入智能座舱系统,开始重新定义人机交互以及用户体验。

当前车市竞争激烈,尤其是智驾系统配置升级的同时,价格却在加剧内卷,伴随智能座舱同质化严重等背景下,AI智能座舱通过功能优化、应用创新实现的多模态、拟人化、差异化的人机交互体验,提升产品的情绪价值,带来更高的溢价和复购率,将是各大车企冲出重围的有效策略。

今年以来,各大车企主力车型开始在座舱比拼“端侧小模型”,并创新各类生成式AI应用,通过集成语音/手势/触控等方式打造更具智能化、多模态的差异化用户体验,加速迈向AI智能座舱”时代。

01 座舱SOC平台迭代加速舱驾融合与大模型上车,首先将会对座舱计算平台提出了新的要求。

2021年,高通8155平台才开始大规模量产,2023年下半年,8295开始陆续上车,而8755的量产时间预计在2025年,座舱硬件平台的迭代速度明显提速。

根据公开消息统计来看,目前已经有华阳、北斗智联、车联天下、航盛、中科创达等一批供应商吩咐推出了基于高通8775平台的舱驾融合方案。

今年北京车展上, 哪吒汽车与高通、车联天下发布Snapdragon Ride Flex(SA8775P)舱驾融合平台。该方案于高通8775单芯片平台,哪吒汽车计划于2025年Q2在量产车上搭载该平台。

此外,丰田、大众两家汽车巨头,也基本敲定高通8775的定点项目,德赛西威、博世两家Tier1预计将深度参与上述项目。

通过单芯片的舱行泊方案,来替代此前高通8155+英伟达Orin的芯片(智舱+智驾)的两套独立方案,实现软件和应用的打通,并同步降低成本,成为了主机厂、Tier 1们接下来的主要设计方案。

而根据各大供应商的方案总结来看,基于8755单芯片平台,除了丰富的智能座舱功能外,还可集成DMS/OMS/CMS/ AVM功能,还可实现AI语音大模型的部署,智驾功能方面,最高可实现城市熟路模式或者通勤NOA,泊车方面最高可以支持到HPA。

多位车企人士以及Tier 1人士表示,舱驾融合与大模型应用,正在快速驱动座舱芯片平台快速迭代。

在当前座舱芯片平台中,功能集成已经趋于饱和,很难支持AI大模型的部署,尤其是AI模型已经开始从云端部署向车端+云端部署架构过渡,对端侧模型中较为高阶的实时推理、任务编排等功能支持已经明显不足。

当前各大车企均在规划下一代AI智能座舱车型,对下一代座舱平台的部署也在加速提上日程。因此,无论是芯片供应商还是各大系统厂商都需要快速推出高性能产品及相关解决方案。

这其中,本土座舱芯片供应商芯驰科技已经率先面向舱行泊一体/舱驾一体 + AI座舱实现了完善的产品系列部署。

资料显示,芯驰舱之芯X9系列集成了高性能CPU、GPU、AI加速器以及视频处理器,全面覆盖各个时代的座舱处理器需求,包括入门级到旗舰级座舱应用场景,并且其也一直在积极引领AI座舱产品的发展。

早在2023年,其变发布了AI座舱的第一代产品X9SP,实现了AI算法的本地部署和加速。

资料显示,X9SP可支持车内多模态感知和云端大模型交互,基于芯驰X9SP的AI座舱,车内用户情绪识别、手势交互、智能导航、主动推荐、自动生成通话摘要等智能化功能均可流畅实现。

在2024年4月的春季发布会上,其重磅发布新一代的X9CC,面向中央计算+区域控制电子电气架构,该芯片内置高性能AI单元,支持OMS/DMS、语音识别等AI应用的部署;支持大模型本地+云端混合部署,可很好的满足本地多模态感知的需求,并能同步支持高阶智驾(行车+泊车)算法部署。

接下来,芯驰将进一步推出AI座舱处理器X10,更高效的支持Transformer架构,支持大模型纯端侧部署,为用户带来更安全、更高效、更加个性化的AI座舱体验。

02 AI座舱创新应用加速落地AI大模型开始从语音、多模态交互、个性化场景,以及更多创新智能应用等方面全面赋能新一代智能座舱。

2024年以来,多家车企已经从车载语音助手作为突破口,推进大模型在智能座舱中的应用。

通过深度 学习和自然语言处理技术,大型模型能够更好地理解和解析用户的 语音指令,大模型具有更丰富的知识储备、更强大的语义理解能力。让语音交互更拟人、更智能、更有趣,还能基于以上能力拓展多种创新的场景应用,

另外大模型技术的多模态特点可以打通视觉、听觉、触觉等多模态应用,从而带动交互模式从单一语音/视觉交互,进入多模交互阶段。

例如蔚来NOMI GPT端云多模态大模型正式上线后,NOMI拥有了更强大的理解和生成能力,可实现一句话实现设定 AI 场景,还可以拟人化的“趣聊”,以及基于大模型百科“ 回答各种奇妙问题和等等。

理想汽车基于全自研多模态认知大模型Mind GPT ,座舱AI语音助手“理想同学”进化成为用车助手、出行助手、娱乐助手和实时联网的百科老师。

并实现了语音融合视觉感知的多模态交互,包括可以通过手势指代进行车控指令执行,以及手势交互隔空操控后排屏幕。

理想汽车智能空间高级总监李娟指出,下阶段将基于大模型的感知-理解-决策-执行过程,配合专业模型可实时为用户提供主动场景推荐等等。“这将是更高阶段的人机交互形态。”

北汽智能座舱总师 赵亨利介绍,北汽也在快速部署基于大模型技术的智能座舱应用,包括基于自然语音交互的闲聊模式、风格化回复+发音人音色=特色化的语音回复的人设模式、汽车任务大师、主动生成情景模式等等,另外还可以基于深度学习和大语言模型,驱动智能调度的场景引擎,来打造“以对话为主,以触控为辅”的座舱交互等等。

与此同时,大模型的落地也将将加速智能座舱软硬件尤其是软件能力升级智能座舱也会向 人机主动式交互快速进化。

在AI智能座舱快速发展下,包括大模型、车载语音等多个赛道也将大大受益。

目前,已经有百度、商汤、华为等拥有大模型技术的厂商相继推出智能座舱产品。在车载语音方面,科大讯飞、云知声、思必驰等供应商均有推出相关产品。

云知声智慧座舱解决方案中心总经理鲍晴峰指出:端侧软硬件平台的提升,助力边缘侧大模型加速落地。与此同时, AI模型开始从云端分流到终端,端云结合的模式,针对特定任务场景,对大模型进行小型化、精确化处理将成为勒新的趋势,这将有效降低对端侧算力的要求。

据介绍,云知声自研山海大模型目前已经在车载行业落地了多个项目。

云知声智慧座舱端侧大模型包括语音大模型和应用大模型,其中语音大模型将语音识别、语义理解、语音合成全链端侧处理,实现更自然、更懂你、更有趣的交互效果。例如通过语音识别大模型不仅可以支持多语种、多方言,且准确识别率和识别效率均能大幅升级;语义理解大模型则能很好的帮助语音交互系统实现“懂你的自然语言”。

基于应用大模型则能拓展多场景多模态交互用车场景,包括用车场景、出游场景、主动关怀场景、健康场景等,并能针对场景提供更专业、个性化的生成内容。还可以可基于山海大模型的技术能力,打造AI百变人设,实现“畅聊”,打造用户的“知心的朋友”。

“我们最终目的是通过这些大模型让未来的智慧座舱变成用户专属的智能助手,提供给用户更多的服务、陪伴,同时通过AI能力的提供,助力车厂更好的基于用户运营,实现更长久的价值与收益。” 鲍晴峰表示。

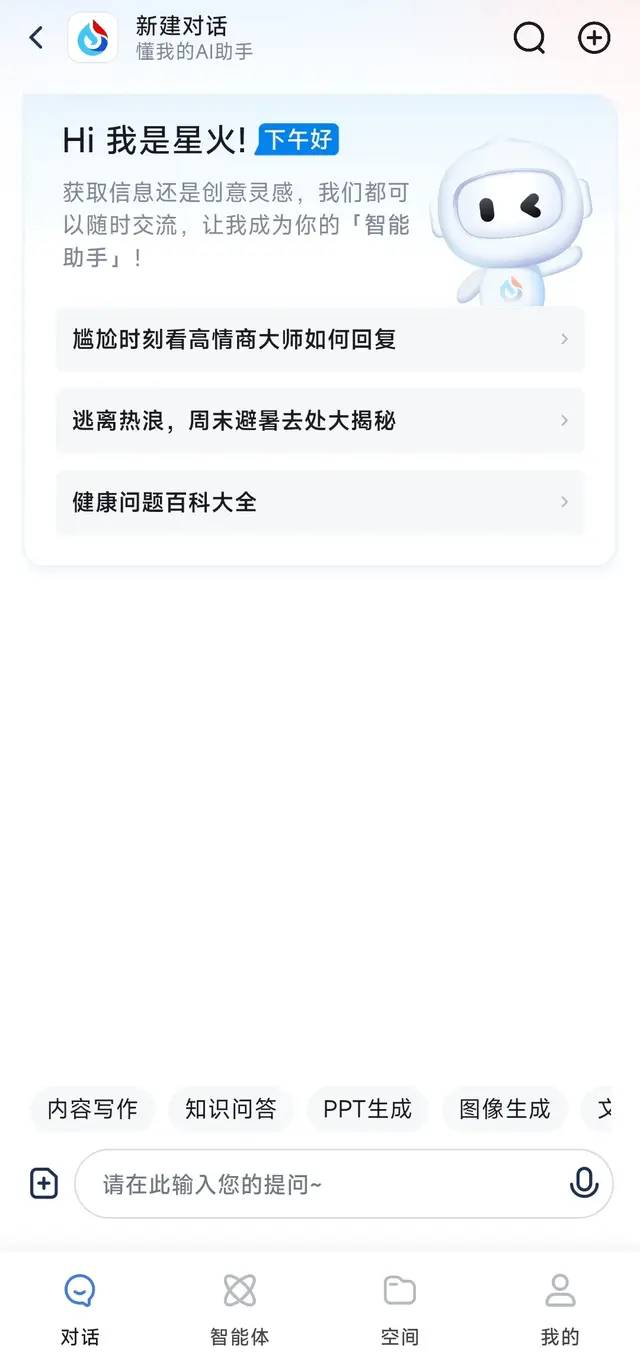

科大讯飞基于自研星火大模型推出了星火智能座舱OS,包括星火汽车助理和星火场景应用、星火汽车APP三大部分,其中星火汽车助力基于星火汽车大模型深度学习、强大的语义理解能力,通过将语音与视觉模态深度融合能力,带来了更加自然、自由、智能的人机交互体验。

并且火星火汽车助理还具备丰富的知识库和在线查询能力,并能够实时监测理解车辆状况,能够精准解答用户用车的各类问题,真正化身无所不知、更懂用户的汽车助手。

此外,星火大模型同时还全面赋能用户出行的各大高频应用场景,并基于场景融合数据打造各不相同的座舱服务,助力车型实现更加人性化、沉浸式的用户体验。

03 AI座舱+智驾,大有可为舱驾融合趋势下,智能座舱在人机交互方面还大有可为,或者说,舱驾两大系统的融合,将能更进一步带来用户体验的升级。

德赛西威的相关负责人指出,智能驾驶系统的快速升级,将影响到用户与座舱的交互,智能驾驶越来越多的功能、越来越丰富的场景需要通过智能座舱向用户传递。与此同时,在行车过程中,用户对智能座舱的需求也不断提高。

他指出,智能座舱与智能驾驶两大域衔接了人-车-环境几大要素,舱舱驾融合架构下,AI座舱也将能为智能驾驶体验赋能,例如通过结合语音、视觉等警示提醒,从而实现具备深度体验智驾感受。

佛瑞亚相关人士也表示,舱驾融合通过将座舱、ADAS的应用相结合将能衍生出非常多新功能和新的交互模态,也就有了更多的附加价值及驾驶者的安全体验。

例如通过语音、手势来激活泊车或者影响ADAS的功能,一方面增强了互动的体验感、功能链接的整体感受,另一方面,通过更直观的HMI显示,来增强了用户体验的整体性,以及对功能的可靠性信任感。

或者实现CMS交互维度升级,针对后车、行人做一些标注,通过CMS显示;或者通过与DMS或者OMS的联动,实现在不同天气、环境情况下提供差异化的图像质量,塑造场景化体验等等。

据介绍,目前佛吉亚也做了相关应用场景的开发。

还有行业人士指出,当前ADAS系统和座舱系统两大领域的交互非常少,尤其是体现在用户端的交互场景非常有限。

亿咖通科技产品高级总监龚思颖介绍,亿咖通基于中央计算平台所打造的舱驾一体大模型架构,引入AI大模型应用,不仅打造超拟人AI出行助手,还能实现真拟人的驾驶体验,全面提升智能汽车的用户出行体验。

首先智驾系统规控的推理决策将不再是单纯的依据ADAS感知系统的数据,而是通过多维度、多模态的数据综合去处理,包含舱内舱外的感知数据,舱内舱外的声音数据,底盘的感知数据以及车联网数据等等,融合进行统一计算。而规控环节不再是局限在单独的智驾域,而是基于集中的中央计算平台,类似于人类大脑的决策过程,然后才是底盘的执行环节。

以车内有宝宝的场景为例,整车做智能驾驶决策时,不单考虑车外感知信息,同时也会将舱内儿童的感知信息融合计算,从而在自动驾驶过程中采取更为平稳的驾驶风格。还可以将车外感知信息与车外的声音信息融合纳入决策,例如在行车过程中,碰到像警车、救护车、消防车等特殊场景时,系统就能更好的优化自动驾驶过程中的变道、加速、超车等执行策略。

由以上来看,下一代智能座舱正在朝着多模态、场景化、个性化、主动式等高阶智能化趋势快速进化,伴随着创新应用与场景拓展探索,新的机会和挑战已经到来。